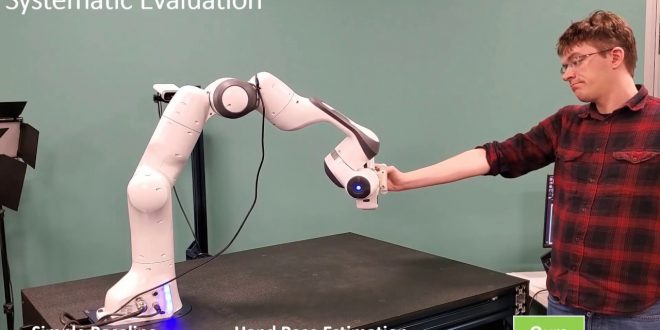

به دنبال ساخت ربات هایی که بتوانند به طور امن و مؤثر در انبار ها و یا خانه با انسان ها همکاری داشته باشند، محققین NVIDIA در آزمایشگاه پژوهشی رباتیک هوش مصنوعی سیاتل یک روش جدید برای تحویل اشیاء از انسان به ربات به وجود آورده اند. در این روش، ربات در نیمه راه، شیء را از انسان تحویل می گیرد.

سیستم جدید که نوعی اثبات مفهوم است، منجر به تحویل مؤثرتری نسبت به رویکرد های قبلی می شود. این سیستم به طور بالقوه می تواند به ربات های انبار و حتی دستیار های آشپرخانه کمک کند تا بهتر با انسان ها تعامل و همکاری داشته باشند.

مسئله اصلی که در این جا به آن پرداخته شده است، نیاز به ساخت یک سیستم ادراکی است که بتواند به طور دقیق، دست و اشیاء را در حالت های مختلف شناسایی کند. در اغلب موارد دست و اشیاء یکدیگر را می پوشانند و مانع تشخیص یکدیگر می شوند. همچنین انسان ممکن است در حین تحویل شیء به ربات، تمرکز خود را روی انجام کار دیگری قرار دهد. تیم تحقیقاتی برای حل این مشکل، رویکرد خود را به دو فاز مختلف تقسیم کرده اند.

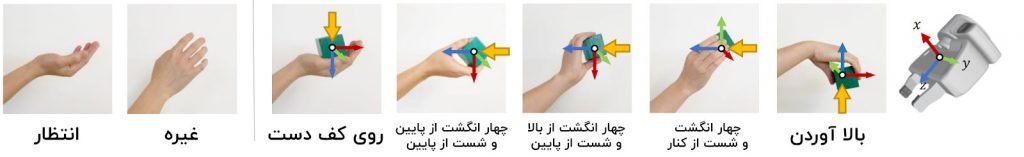

در ابتدا، یک مجموعه از انواع گرفتن تعریف می شود که نحوه گرفته شدن یا چنگ زدن شیء توسط دست انسان در هنگام تحویل اشیاء را توصیف می کند.

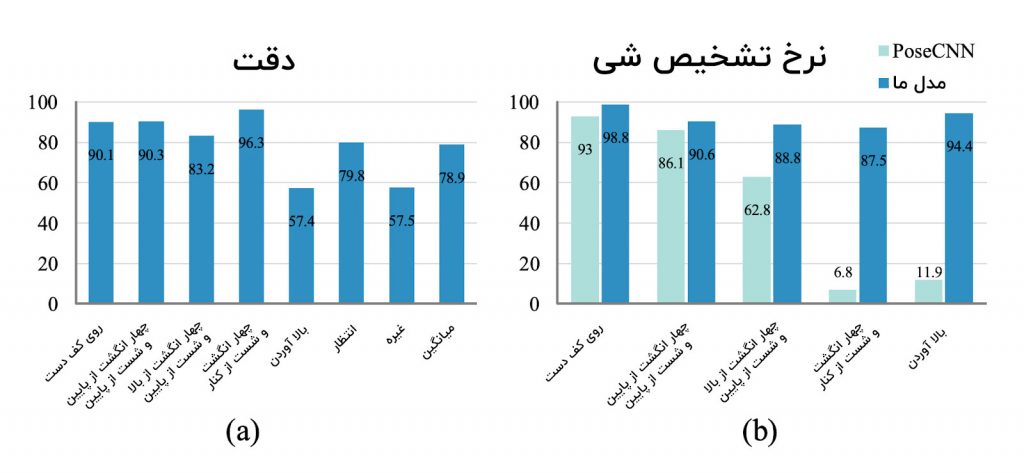

پژوهشگران در مقاله خود با عنوان ” Human Grasp Classification for Reactive Human-to-Robot Handovers ” توضیح داده اند که در هنگام گرفتن یک بلوک، دست می تواند حالت های مختلفی به خود بگیرد. این حالت در یکی از دسته های on-open-palm (روی کف دست)، pinch-top (چهار انگشت از بالا و شست از پایین)، pinch-button (چهار انگشت از پایین و شست از پایین)، pinch-side (چهار انگشت و شست از کنار) یا lifting (بالا آوردن) تعریف می شود. اگر دست هیچ چیزی را نگرفته باشد، پس یا منتظر تحویل شیء از سوی ربات است، و یا هیچ کار خاصی انجام نمی دهد.

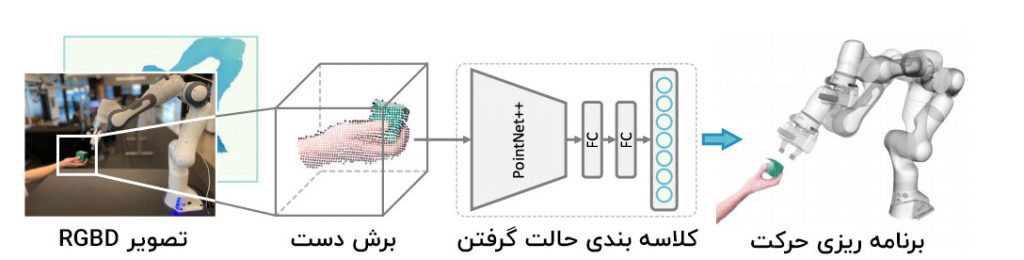

محققین در ادامه یک شبکۀ عصبی عمیق را جهت پیش بینی دسته های مختلف گرفتن بر اساس ابر نقطه ای آموزش داده اند. آن ها با استفاده از دوربین کینکت RGBD مایکروسافت Azure ، یک مجموعه داده خاص، حاوی هشت شیء با شکل های مختلف دست و حالت های متنوع دست را به وجود آورده اند.

محققین در ابتدا یک تصویر نمونه از حالت گرفتن را به یک فرد نشان می دهند. سپس فرد به اجرای حالت های مشابه از این تصویر پرداخته و در این حین، ویدیویی از این اجرا، به مدت بیست الی شصت ثانیه ضبط می شود. کل تصاویر موجود در این ویدیو به عنوان یکی از انواع مختلف گرفتن، برچسب گذاری می شود. در طول ضبط فیلم، فرد مجری باید بدن خود را در جهات و موقعیت های مختلف تغییر دهد. حالت گرفتن برای هر دو دست راست و چپ ضبط شده و به طور کلی، ۱۵۱۵۵۱ تصویر برای مجموعه داده جمع آوری شده اند.

دو نوع حالت دست خالی و پنج نوع حالت گرفتن، راه های مختلف گرفتن اشیاء به وسیله کاربر انسانی را نشان می دهند. این نمونه ها، همگی به جهات مختلف گرفتن استاندارد ربات جهت به حداقل رساندن تلاش انسان در طول عملیات تحویل مربوط می شوند (سیستم مختصات و پیکان زرد در تصویر).

در فاز بعدی، جهت گیری حالت گرفتن ربات بر اساس گرفتن انسان تنظیم می شود.

این کار از طریق آموزش یک شبکۀ کلاس بندی حالات گرفتن انسان صورت می گیرد. این آموزش به وسیلۀ معماری PointNet++ انجام می شود، چرا که یک معماری ساده و موفق در بسیاری از برنامه های کاربردی رباتیک است. معماری PointNet++ پیش تر در سیستم اجرای از راه دور بدون نشانه و همچنین ایجاد حالت های گرفتن به کار رفته است.

با وجود یک ابر نقطه ای برش یافته حول دست، شبکه می تواند این ابر را به یکی از دسته های مربوط به حالت گرفتن کلاس بندی کند. از این کلاس بندی بعد ها جهت طرح ریزی حالت گرفتن ربات استفاده می شود.

در این مرحله، دسورالعمل های گرفتن استاندارد به ربات تعلیم داده می شود تا احتمال گرفتن دست انسان توسط ربات، کاهش یابد. این امر همچنین باعث می شود تا حرکت و خط سیر ربات، تا حد ممکن طبیعی به نظر برسد.

سیستم با استفاده از کارت گرافیک تایتان X انویدیا و CUDA 10.2 و چارچوب PyTorch آموزش یافته است. تمام آزمایشات با یک کارت گرافیک RTX 2080Ti انویدیا به انجام رسیده اند.

طبق گفتۀ پژوهشگران، در مجموع می توان گفت که سیستم پیشنهادی دائما نرخ موفقیت در عملیات گرفتن را بهبود بخشیده و زمان اجرای کلی و همچنین مدت زمان آزمون را در مقایسه با هر دو روش پایه، کاهش می دهد. این موضوع به نوبۀ خود، اثربخشی و قابلیت اطمینان روش پیشنهادی را اثبات می کند.

در آزمایش های بعدی، پژوهشگران سعی دارند تا سیستم را بر اساس انواع گرفتن های بیشتر آموزش داده و مجموعه داده های خود را غنی تر سازند.

بیشتر بخوانید :

- پلاک خوان های شهر گرینزبوروی آمریکا فعلاً قرار نیست افزایش پیدا کنند

- فرماندار اوکلند از پلاک خوان ها حمایت می کند اما مخالفان در اثربخشی آن تردید دارند

- لبنان استفاده از پلاک خوان های خودکار را تایید کرد

- چالش های مدیریت کلاس با ابزار جدید تشخیص چهره هوش مصنوعی

- آیا می توان از دوربین های ترافیکی برای گرفتن رانندگان الکلی استفاده کرد؟

مجله هوش مصنوعی شهاب

مجله هوش مصنوعی شهاب