در مقاله های قبلی توضیح دادیم که رگرسیون چیست و چگونه می تواند در عمل مورد استفاده قرار گیرد. اکنون می خواهیم بیشتر مدل های رایج یادگیری ماشین که در کاربرد های عملی مورد استفاده هستند را بررسی کنیم تا بتوانیم بجای اینکه نظریات آن ها را توضیح دهیم، زمان بیشتری را صرف ساخت وساز وبهبود مدل کنیم. بیایید شروع کنیم.

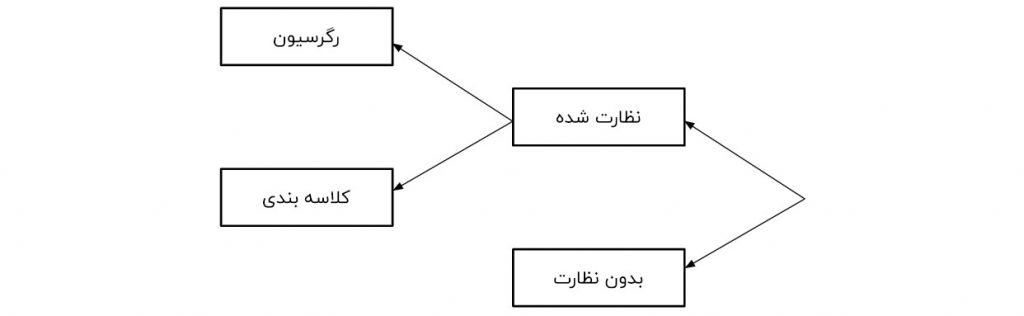

تمامی مدل های یادگیری ماشین به صورت نظارت شده یا بدون نظارت طبقه بندی می شوند. اگرمدل یک مدل نظارت شده باشد، این مدل به صورت یک مدل رگرسیون یا کلاسه بندی، دسته بندی می شود. ما خواهیم دید این اصطلاحات به چه معنا هستند و مدل های مربوط به هر دسته کدام اند.

یادگیری نظارت شده

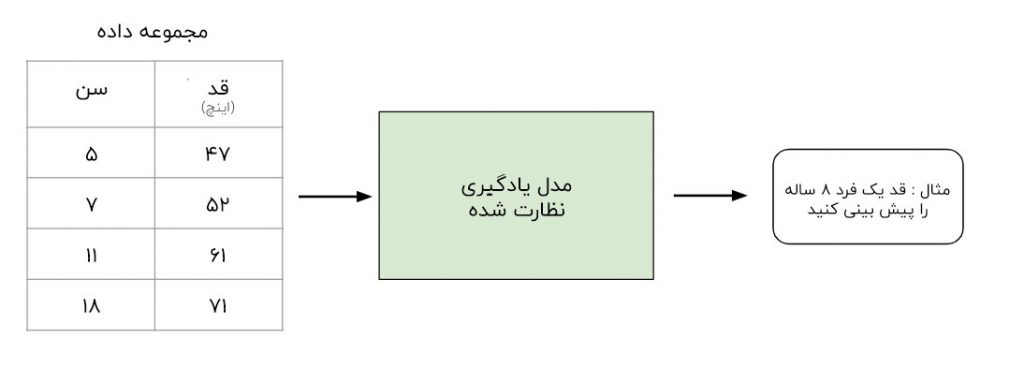

یادگیری نظارت شده شامل یادگیری تابعی است که ورودی را به خروجی براساس جفت ورودی _ خروجی ترسیم می کند.

برای مثال ،اگر یک مجموعه داده با دو متغیر سن ( ورودی ) وارتفاع ( خروجی ) داشته باشیم، می توانیم یک مدل یادگیری نظارت شده را برای پیش بینی ارتفاع یک فرد براساس سن آن ها اجرا کنیم.

برای تکرار دوباره ، در میان یادگیری تحت نظارت ، دو زیر گروه وجود دارد: رگرسیون و کلاسه بندی.

رگرسیون

در مدل های رگرسیون ، خروجی پیوسته است. در زیر برخی از رایج ترین انواع مدل های رگرسیون نشان داده شده است.

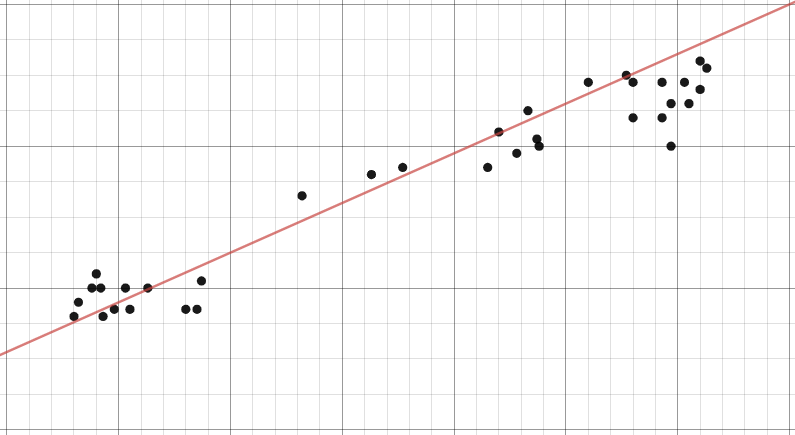

رگرسیون خطی

ایده رگرسیون خطی تنها یافتن خطی است که بهترین برازش را با داده ها دارد. توسعه رگرسیون خطی شامل رگرسیون خطی چندگانه ( با پیداکردن یک صفحه از بهترین برازش ) رگرسیون چند جمله ای ( یافتن منحنی بهترین برازش ) است. می توانید درمورد رگرسیون خطی در مقالات قبلی بیشتر یاد بگیرید.

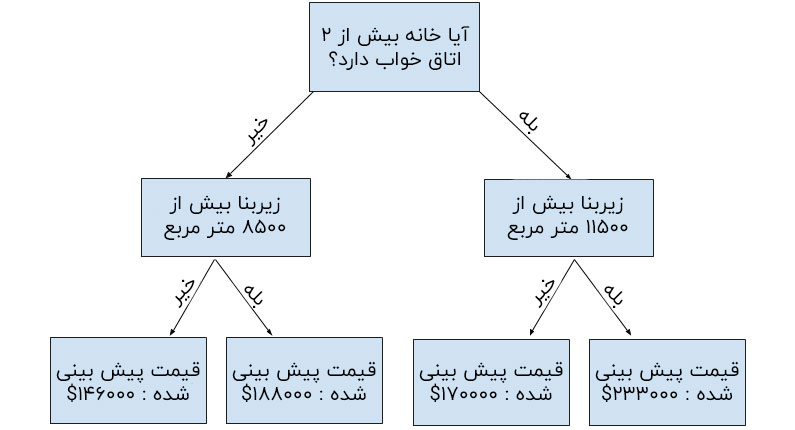

درخت تصمیم گیری

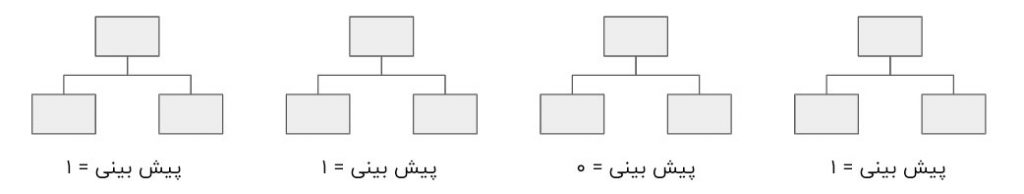

درخت تصمیم گیری یک مدل محبوب است که در عملیات تحقیق، برنامه ریزی استراتژیک و یادگیری ماشین مورد استفاده قرار می گیرد. هرمربع بالا یک نود نامیده می شود و هرچه گره های بیشتری داشته باشید، درخت تصمیم گیری شما دقیق تر خواهد بود ( به طور کلی ). آخرین گره های درخت تصمیم گیری ، که درآن تصمیم گرفته می شود، برگ های درخت نامیده می شوند. نمودار درختی تصمیم گیری شهودی و آسان است ، اما وقتی به بحث دقت می رسد، نتیجه ی آن کم می شوند.

جنگل تصادفی

جنگل تصادفی یک تکنیک یادگیری جمعی است که از درخت های تصمیم گیری ایجاد می شود. جنگل تصادفی شامل ایجاد چند درخت تصمیم گیری با استفاده از پایگاه داده های بوت استرپ راه اندازی شده داده های اصلی و انتخاب تصادفی زیر مجموعه ای از متغیرها را درهر گام از درخت تصمیم گیری انتخاب می کند. سپس مدل حالت تمام پیش بینی های هر درخت تصمیم گیری را انتخاب می کند. هدف این کار چیست؟ با تکیه برمدل ” برنده اکثریت ” ریسک خطای ناشی از یک درخت منفرد را کاهش می دهد.

به عنوان مثال ، اگر یک درخت تصمیم گیری را ایجاد کنیم ، مورد سوم ، پاسخ را صفر پیش بینی خواهد کرد اما اگر بر مد هر ۴ درخت تصمیم گیری تکیه کنیم، مقدار پیش بینی شده ۱ خواهد بود. این قدرت جنگل های تصادفی است .

StatQuest این کار را با جزئیات بیشتر به صورت خارق العاده ای انجام می دهد. می توانید از اینجا ببینید

شبکه عصبی

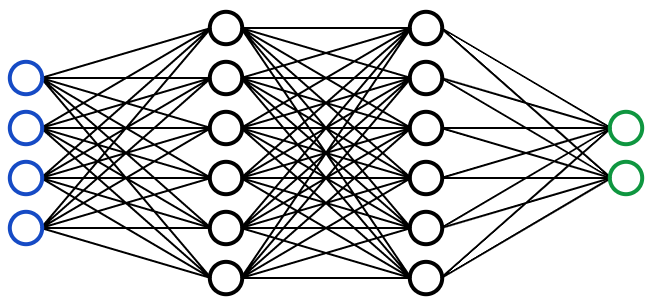

شبکه عصبی یک مدل چند لایه ای الهام گرفته از مغز انسان است. مانند نورون های مغز ما ، دایره ها بالای یک گره هستند. دایره های آبی نمایانگر لایه ورودی هستند دایره های سیاه معرف لایه های پنهان هستند و دایره های سبز، معرف لایه خروجی هستند. هرگره لایه های پنهان ، تابعی را نشان می دهد که ورودی از آن ها عبود می کنند ، درنهایت منجر به خروجی در دایره های سبز می شوند.

شبکه های عصبی در واقع بسیار پیچیده و ریاضی هستند، بنابراین من به جزئیات آن نمی پردازم ، اما…

مقاله تونی ییو یک توضیح آغازین از فرآیند پشت شبکه های عصبی ارائه می دهد. مقاله ترجمه شده را می توانید از اینجا بخوانید.

اگرمی خواهید یک قدم بیشتر بردارید و ریاضیات پشت شبکه عصبی را درک کنید ، این کتاب رایگان آنلاین را بررسی کنید .

اگر یک یادگیرنده دیداری/ شنیداری هستید، ۳Blue1Brown یک مجموعه ی شگفت انگیز در مورد شبکه های عصبی و یادگیری عمیق در یوتیوب دارد.

کلاسه بندی

در مدل های کلاسه بندی، خروجی گسسته است. درزیر برخی از انواع مدل های کلاسه بندی آورده شده است.

رگرسیون لجستیک

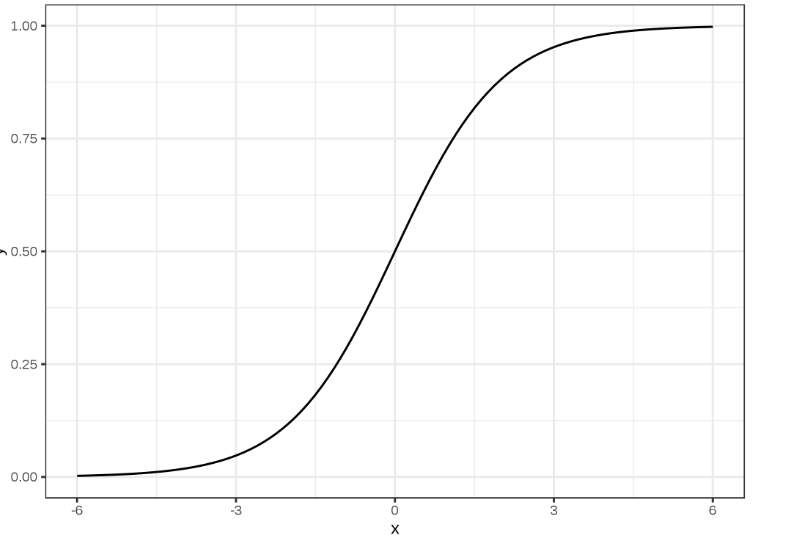

رگرسیون لجستیک شبیه به رگرسیون خطی است اما برای مدل کردن احتمال تعداد متناهی از نتایج معمولا دو یا چند خروجی وجود دارد که چرا رگرسیون لجستیک در رگرسیون خطی در هنگام مدل سازی احتمالات نتایج استفاده می شود. در اصل ، یک معادله لجستیک به گونه ای ایجاد می شود که مقادیر خروجی فقط بین صفر و یک باشد.

ماشین بردار پشتیبان

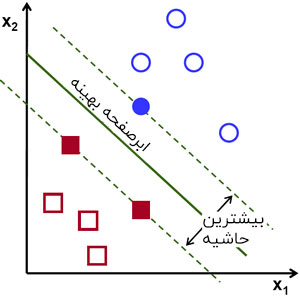

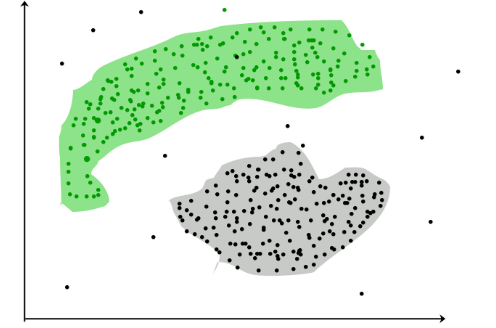

ماشین بردار پشتیبان یک تکنیک کلاسه بندی نظارت شده است که درواقع می تواند نسبتا پیچیده باشد ، اما در پایه ای ترین سطح کاملا شهودی است.

فرض کنیم دو کلای داده وجود دارد. یک ماشین بردار پشتیبان یک ابر صفحه یا مرز بین دو کلاس داده را پیدا می کند که حاشیه بین دو کلاس را به حداکثر می رساند .صفحات زیادی وجود دارند که می توانند کلاس را از هم جدا کنند، اما فقط یک صفحه می تواند حاشیه یا فاصله بین کلاس ها را به حداکثر برساند.

اگر می خواهید جزئیات بیشتری به دست آورید Savan یک مقاله ی خوب در این زمینه نوشته است که می توانید نسخه فارسی آن را از اینجا مطالعه کنید.

بیز ساده

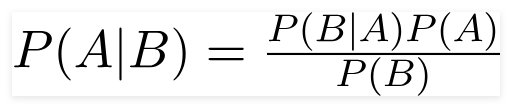

بیز ساده یک کلاسه بند محبوب دیگر در علوم داده است. ایده پشت آن توسط Bayes Theorem انجام شد :

درحالیکه تعدادی از فرضیات غیرواقعی دررابطه با بیز ساده وجود دارد ) چون آن را ” ساده ” نامیده اند) ثابت شده است که بیشتر اوقات عمل به خوبی می کند و راه اندازی آن نیز نسبتا سریع است .

اگر میخواهید در مورد آن ها بیشتر بدانید به اینجا رجوع کنید.

درخت تصمیم گیری ، جنگل تصادفی، شبکه عصبی

این مدل ها همان منطق مشابه پیشین را دنبال می کنند. تنها تفاوت این است که خروجی آن ها گسسته است و نه پیوسته.

یادگیری بدون نظارت

برخلاف یادگیری نظارت شده ، یادگیری بدون نظارت برای استنتاج و یافتن الگو از داده های ورودی بدون نیاز به نتایج برچسب گذاری شده، استفاده می شود. دو روش اصلی مورد استفاده در یادگیری بدون نظارت شامل خوشه بندی و کاهش ابعاد می باشد .

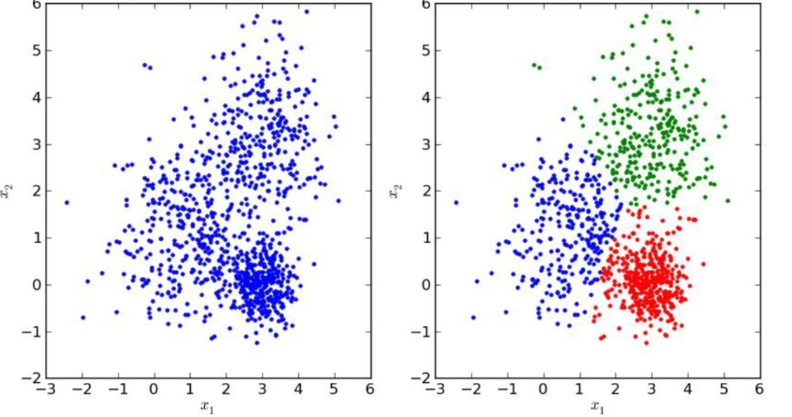

خوشه بندی

خوشه بندی یک تکنیک بودن نظارت است که شامل گروه بندی یا خوشه بندی از نقاط داده باشد. اغلب برای تقسیم بندی مشتری، تشخیص تقلب و کلاسه بندی اسناد به کار می رود.

روش های خوشه بندی مشترک عبارتند از : خوشه بندی K-Means، خوشه بندی hierarchical،خوشه بندی تغییر میانگین و خوشه بندی مبتنی بر چگالی. درحالیکه هر تکنیک روش متفاوتی درپیدا کردن خوشه ها دارد، هدف همه ی آن ها رسیدن به یک چیز است.

کاهش ابعاد

کاهش ابعاد فرآیند کاهش تعداد متغیر های تصادفی تحت نظر به دست آوردن یک مجموعه از متغیرهای اصلی است.

به عبارت ساده تر، فرآیند کاهش ابعاد مجموعه ویژگی های شما ( به عبارت ساده تر ، کاهش تعداد ویژگی ها ) است. بیشتر تکنیک های کاهش ابعاد را می توان به عنوان حذف ویژگی یا استخراج ویژگی دست بندی کرد.

یک روش معروف کاهش ابعاد ، تحلیل مولفه های اصلی نامیده می شود .

تحلیل مولفه های اصلی ( PCA )

در ساده ترین حالت ، PCA شامل تبدیل داده های ابعاد بالای پروژه ( به عنوان مثال ۳ بعد ) تا یک فضای کوچکتر ( به عنوان مثال ۲ بعد ) است. این کار منجر به بعد پایین تر داده ها ( ۲ بعد به جای ۳ بعد ) است درحالیکه تمام متغیرهای اصلی را در مدل نگه می دارد .

کمی ریاضیات در این مورد وجود دارد. اگرمی خواهید درباره آن بیشتر بدانید این مقاله عالی را درمورد PCA را بررسی کنید.

نتیجه گیری

مشخصا اگر شما بخواهید به هریک از مدل وارد شوید ، پیچیدگی های بسیاری وجود دارد اما این مطلب باید یک دید کلی از نحوه کار الگوریتم یادگیری ماشین به شما بدهد که الگوریتم ها چگونه کار می کند.

اگر این مطلب برای شما مفید بوده، برای ما نظر بگذارید.

مجله هوش مصنوعی شهاب

مجله هوش مصنوعی شهاب

سلام، روز بخیر

ممنونم بابت مطالب ارائه شده در صفحه، بسیار عالی بودند.

بنده روی یک مقاله کار میکنم که باید تعدادی شاخص کلیدی در مسئله انتخاب تامین کننده رو شناسایی کنم و در ۴ بخش چابک، سبز، تاب آور و ناب تقسیم بندی کنم. شاخص های بسیار زیادی توی مرور ادبیات پیداکردم که هرکدام به نحوی مهم و تاثیر گذار هستند. سوال بنده اینه که اگر بخوام از بین این شاخص ها تعدادی کمی رو انتخاب و دسته بندی بکنم و به عنوان شاخص های اصلی در مسئله استفاده کنم، شما کدوم الگوریتم ماشین لرنینگ رو توصیه میکنید برای انجام این کار؟؟

سلام

یکی از روشهای متداول برای این نوع کارها استفاده از تلفیق الگوریتم ژنتیک (یا موارد مشابه مثل PSO) با یک الگوریتم یادگیری مثل شبکه عصبی است